Udemy - Big Data Analytics con Python e Spark 2.4 Il Corso Completo [Ita]

Informazioni

6

1

20

Ultimo aggiornamento: 2026-02-08 04:23

Seed

Leech

Completi

Hash:

3e192608fb404e0cf4bfa7a7ecfd35616ad1f486

Download

Faceva sì che tutti, piccoli e grandi, ricchi e poveri, liberi e schiavi ricevessero un marchio sulla mano destra e sulla fronte e che nessuno potesse comprare o vendere se non chi avesse il marchio,

cioè il nome della bestia o il numero del suo nome.

VARIANTE

La Verità vi farà Liberi

Udemy - Big Data Analytics

con Python e Spark 2.4 Il Corso Completo [Ita]

*Si desidera ringraziare NoNames/l autore Originale

Cosa Imparerai

-Utilizzare Python e Spark per Analizzare i Big Data

-Utilizzare MLlib per Creare Modelli di Machine Learning con i Big Data

-Installare e Configurare PySpark su una Macchina Virtuale

-Installare e Configurare PySpark con Amazon EC2

-Creare un Cluster di Macchine per PySpark con Amazon EMR

-Utilizzare gli Amazon Web Service (AWS) per l'Analisi di Big Data

-Imparare ad Utilizzare DataBricks per l'Analisi di Big Data

-Utilizzare l'RDD per Elaborare Dati in Parallelo

-Utilizzare il DataFrame per Processare Dati in Maniera Efficiente

-Utilizzare Spark Streaming per elaborare flussi di dati in Tempo Reale

-Creare un Modello di Sentiment Analysis con il Dataset di Yelp (5 GB !)

-Processare Tweets pubblicati su Twitter in Tempo Reale

Descrizione

Impara a utilizzare le Ultime Tecnologie per l'Analisi dei Big Data con il linguaggio di Programmazione più popolare al mondo - Spark e Python !

Siamo entrati nell'era dei Big Data, oggi i dati sono il nuovo petrolio e sapere come elaborarli e analizzarli vuol dire avere un posto di lavoro garantito in un futuro molto prossimo e un vantaggio competitivo enorme rispetto ai rivali in affari.

In questo corso impareremo a lavorare con i Big Data utilizzando Spark, il framework per il calcolo distribuito più popolare al mondo, usato in produzione da giganti come Amazon, Microsoft, Oracle, Verizon e Cisco.

Cosa faremo durante il corso ?

Nella prima sezione del corso introdurre l'argomento Big Data, vedendo cosa sono, da dover arrivano e come possono essere sfruttati.

Vedremo quali sono le principali tecnologie utilizzate per i Big Data: Apache Hadoop, Hadoop MapReduce e Spark, chiarendone le differenze, i punti deboli e i punti di forza.

Nella seconda sezione vedremo come installare e configurare Spark su una macchina locale, prima usando VirtualBox per creare una macchina simulata sulla quale installare Ubuntu, poi creando una macchina remota sfruttando gli Amazon Web Service, nello specifico AWS EC2.

Nella terza sezione impareremo a creare un cluster di macchine con Spark e lo faremo in due modi differenti:

-Usando AWS EMR (Elastic MapReduce)

-Usando DataBricks, piattaforma per l'analisi dei Big Data co-fondata dallo stesso creatore di Spark.

Nella quarta sezione studieremo la principale struttura dati di Spark: il Resilient Distributed Dataset (RDD), introducendo la teoria del suo funzionamento per poi eseguire qualche esercizio pratico per studiarne le API.

Nella quinta sezione ci sporcheremo le mani con il primo laboratorio in cui analizzeremo un dataset contenente 22.5 milioni di recensioni di prodotti su Amazon.

Nella sesta sezione introdurremo una struttura dati a più alto livello che Spark mette a disposizione dalle sue versioni più recenti: il DataFrame, parleremo brevemente della suo funzionamento per poi vedere come può essere utilizzato nella pratica. Vedremo anche come creare una tabella SQL partendo da un DataFrame per poi interrogarla con query di selezione.

Nella settima sezione svolgeremo un secondo laboratorio, usando un DataFrame per analizzare ben 28 milioni di recensioni di film.

Nell'ottava sezione parleremo di serie storiche (time series) e analizzeremo le azioni di Apple dal 1980 ad oggi.

Nella nona sezione parleremo di Machine Learning, scoprendo come funziona e a cosa serve e studiando i due modelli di base rispettivamente per modelli di Regressione e Classificazione:

-La Regressione Lineare

-La Regressione Logistica

Al termine di questa sezione introdurremo il modulo MLlib (Machine Learning Library) di Spark, il quale ci permette di costruire modelli di Machine Learning distribuiti.

Nelle sezioni dieci e undici vedremo come utilizzare il modulo MLlib con le sue API per il Dataframe, per risolvere semplici problemi di regressione e classificazione, come:

-Stimare il valore di abitazioni partendo dalle loro caratteristiche

-Riconoscere un tumore al seno maligno da un'agobiopsia

Nella sezione dodici utilizzeremo le conoscenze acquisite sul Machine Learning e MLlib per costruire un modello di Sentiment Analysis utilizzando il dataset di Yelp, il quale contiene oltre 5 GB di recensioni di locali e attività commerciali.

Per addestrare il modello di Machine Learning sull'intero dataset così grande utilizzeremo un cluster AWS EMR, imparando a configurare un cluster e a importare grandi quantità di dati nel Hadoop File System (HDFS) da un bucket S3 utilizzando l'utility s3-dist-cp.

Nella nona sezione introdurremo uno delle estensioni più hot di Spark: Spark Streaming, che ci permette di analizzare ed elaborare flussi di dati in tempo reale !

Nella decima sezione svolgeremo un progetto usando Spark Streaming e le API di Twitter: monitoreremo tutti i tweets pubblicati in tempo reale, relativi ad un determinato argomento selezionato da noi, e creeremo un grafico interattivo con gli hashtags più popolari !

Perché seguire questo corso ?

I Big Data sono il futuro, sapere come sfruttarli sarà un vantaggio enorme, sia per un professionista che per un imprenditore, non perdere questa occasione!

A chi è rivolto questo Corso

-Chiunque voglia imparare a elaborare grandi quantità di dati in maniera distribuita

-Chiunque voglia imparare a sfruttare il vantaggio competitivo dei Big Data

Requisiti

*Nessun prerequisito particolare è richiesto, solo passione e voglia di imparare a lavorare con i Big Data

Il Corso è composto da:

Files

-

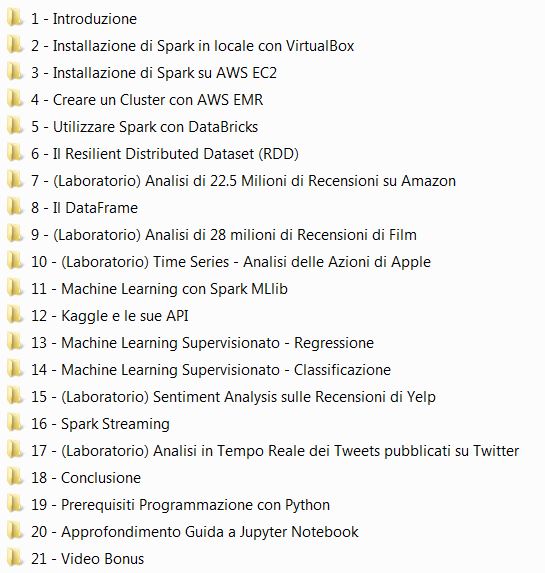

Udemy - Big Data Analytics con Python e Spark 2.4 - Il Corso Completo [Ita]

-

1 - Introduzione

- 1 - Cosa sono i Big Data.mp4 (48.03 MiB)

- 2 - Domande Frequenti.html (1.58 KiB)

- 3 - I vantaggi dei Big Data.mp4 (132.5 MiB)

- 4 - Le tecnologie per i Big Data Spark.mp4 (72.69 MiB)

- 5 - Le tecnologie per i Big Data Hadoop MapReduce.mp4 (67.44 MiB)

- 6 - Leggi questo prima di iniziare.html (1.5 KiB)

-

2 - Installazione di Spark in locale con VirtualBox

- 7 - Usare VirtualBox per Creare una Macchina Virtuale.mp4 (200.86 MiB)

- 8 - Installare Ubuntu sulla Macchina Virtuale.mp4 (121.78 MiB)

- 9 - Installare Pip e Jupyter Notebook.mp4 (74.85 MiB)

- 10 - Installare Java e Scala.mp4 (53.82 MiB)

- 11 - Installare Spark sulla Machina Virtuale.mp4 (145.24 MiB)

-

3 - Installazione di Spark su AWS EC2

- 12 - Creare una Macchina Virtuale con AWS EC2.mp4 (86.03 MiB)

- 13 - Installare Spark sulla Machina Remota.mp4 (190.55 MiB)

- 14 - Non dimenticare questo.html (1.32 KiB)

-

4 - Creare un Cluster con AWS EMR

- 15 - Creazione di un Cluster con AWS EMR (Elastic Map Reduce).mp4 (145.16 MiB)

-

5 - Utilizzare Spark con DataBricks

- 16 - Utilizzare Spark con DataBricks.mp4 (88.05 MiB)

- 17 - Importare i Notebook su DataBricks.mp4 (19.3 MiB)

-

6 - Il Resilient Distributed Dataset (RDD)

- 18 - Introduzione al RDD.mp4 (34.57 MiB)

- 19 - Azioni del RDD.mp4 (69.59 MiB)

- 19 - Notebook del laboratorio.txt (158 B)

- 20 - MapReduce sul RDD.mp4 (67.94 MiB)

- 20 - Notebook del laboratorio.txt (158 B)

- 21 - Notebook del laboratorio.txt (158 B)

- 21 - Trasformazioni sul RDD.mp4 (84.59 MiB)

- 22 - Notebook del laboratorio.txt (158 B)

- 22 - RDD con chiave e valore.mp4 (192.23 MiB)

-

7 - (Laboratorio) Analisi di 22.5 Milioni di Recensioni su Amazon

- 23 - Notebook del laboratorio.txt (158 B)

- 23 - Procuriamoci il Dataset.mp4 (50.85 MiB)

- 24 - Contiamo il numero di valutazioni.mp4 (79.48 MiB)

- 24 - Notebook del laboratorio.txt (158 B)

- 25 - Contiamo il numero di libri.mp4 (31.13 MiB)

- 25 - Notebook del laboratorio.txt (158 B)

- 26 - Contiamo il numero di valutazioni per libro.mp4 (35.63 MiB)

- 26 - Notebook del laboratorio.txt (158 B)

- 27 - Notebook del laboratorio.txt (158 B)

- 27 - Troviamo i 10 libri più valutati.mp4 (83.39 MiB)

- 28 - Calcoliamo la valutazione media per ogni libro.mp4 (176.08 MiB)

- 28 - Notebook del laboratorio.txt (158 B)

- 29 - Notebook del laboratorio.txt (158 B)

- 29 - Troviamo i 10 libri con la valutazione più alta.mp4 (115.43 MiB)

- 30 - Notebook del laboratorio.txt (158 B)

- 30 - Troviamo i 10 recensori più critici.mp4 (101.47 MiB)

-

8 - Il DataFrame

- 31 - Introduzione al DataFrame.mp4 (22.13 MiB)

- 32 - Creazione di un DataFrame.mp4 (59.28 MiB)

- 32 - Notebook del laboratorio.txt (158 B)

- 33 - Modificare lo Schema di un DataFrame.mp4 (52.69 MiB)

- 33 - Notebook del laboratorio.txt (158 B)

- 34 - Notebook del laboratorio.txt (158 B)

- 34 - Operare su Righe e Colonne.mp4 (106.65 MiB)

- 35 - Filtri, Aggregazione e Ordinamento.mp4 (138.95 MiB)

- 35 - Notebook del laboratorio.txt (158 B)

- 36 - Notebook del laboratorio.txt (158 B)

- 36 - Query SQL su un DataFrame.mp4 (42.35 MiB)

- 37 - (Opzionale) Query SQL di Selezione.mp4 (152.33 MiB)

- 37 - Notebook del laboratorio.txt (158 B)

-

9 - (Laboratorio) Analisi di 28 milioni di Recensioni di Film

- 38 - Notebook del laboratorio.txt (158 B)

- 38 - Procuriamoci il Dataset MovieLens.mp4 (47.65 MiB)

- 39 - Creiamo il DataFrame.mp4 (92.19 MiB)

- 39 - Notebook del laboratorio.txt (158 B)

- 40 - Correggiamo lo Schema.mp4 (97.39 MiB)

- 40 - Notebook del laboratorio.txt (158 B)

- 41 - Contiamo il numero di Recensioni Totali e la Media per Utente.mp4 (60.14 MiB)

- 41 - Notebook del laboratorio.txt (158 B)

- 42 - Notebook del laboratorio.txt (158 B)

- 42 - Troviamo l'Utente che ha Scritto più Recensioni.mp4 (30.62 MiB)

- 43 - Notebook del laboratorio.txt (158 B)

- 43 - Troviamo i 10 Film che hanno ricevuto più Recensioni.mp4 (40.59 MiB)

- 44 - Notebook del laboratorio.txt (158 B)

- 44 - Troviamo i 10 Film con le Recensioni più Positive e più Negative.mp4 (146.15 MiB)

- 45 - Notebook del laboratorio.txt (158 B)

- 45 - Troviamo le 10 Recensioni più Recenti.mp4 (23.58 MiB)

- 46 - Notebook del laboratorio.txt (158 B)

- 46 - Troviamo i Film più Visti ogni Anno.mp4 (168.15 MiB)

- 47 - Aggiungiamo Titolo e Genere alla lista dei Film più Visti.mp4 (116.32 MiB)

- 47 - Notebook del laboratorio.txt (158 B)

-

10 - (Laboratorio) Time Series - Analisi delle Azioni di Apple

- 48 - Notebook del laboratorio.txt (158 B)

- 48 - Procuriamoci il Valore Giornaliero delle Azioni di Apple dal 1980 a Oggi.mp4 (32.99 MiB)

- 49 - Creiamo il DataFrame e Correggiamo lo Schema.mp4 (160.92 MiB)

- 49 - Notebook del laboratorio.txt (158 B)

- 50 - Notebook del laboratorio.txt (158 B)

- 50 - Troviamo i Valori Massimi e Minimi.mp4 (50.24 MiB)

- 51 - Notebook del laboratorio.txt (158 B)

- 51 - Troviamo i giorni in cui il Valore è stato inferiore ai 100 $.mp4 (60.08 MiB)

- 52 - Notebook del laboratorio.txt (158 B)

- 52 - Troviamo il Valore Massimo per ogni Anno.mp4 (44.39 MiB)

- 53 - Notebook del laboratorio.txt (158 B)

- 53 - Troviamo l'Anno con i Volumi Maggiori.mp4 (24.77 MiB)

- 54 - Calcoliamo la Variazione delle Azioni dopo il rilascio dell'iPhone.mp4 (105.33 MiB)

- 54 - Notebook del laboratorio.txt (158 B)

-

11 - Machine Learning con Spark MLlib

- 55 - Cosa è il Machine Learning.mp4 (96.15 MiB)

- 56 - I problemi del Machine Learning.mp4 (42.37 MiB)

- 57 - La Regressione Lineare e Logistica.mp4 (103.13 MiB)

- 58 - (Opzionale) L'algoritmo Gradient Descent.mp4 (67 MiB)

- 59 - Introduzione a Spark MLlib.mp4 (43.29 MiB)

- 60 - Altri modelli di Machine Learning.html (1.57 KiB)

-

12 - Kaggle e le sue API

- 61 - Introduzione a Kaggle.mp4 (65.08 MiB)

- 62 - Creazione di un Account.mp4 (21.07 MiB)

- 63 - Utilizzare le API di Kaggle.mp4 (41.53 MiB)

- 64 - Scaricare un Dataset con le API.mp4 (40.38 MiB)

- 65 - Scaricare il Dataset di una Competizione con le API.mp4 (80.85 MiB)

-

13 - Machine Learning Supervisionato - Regressione

- 66 - Notebook del laboratorio.txt (158 B)

- 66 - Procuriamoci il Dataset.mp4 (87.59 MiB)

- 67 - Notebook del laboratorio.txt (158 B)

- 67 - Vettorizzazione delle Features.mp4 (75.42 MiB)

- 68 - Applichiamo la Normalizzazione.mp4 (72.17 MiB)

- 68 - Notebook del laboratorio.txt (158 B)

- 69 - Creare un modello di Regressione Lineare.mp4 (78.92 MiB)

- 69 - Notebook del laboratorio.txt (158 B)

- 70 - Notebook del laboratorio.txt (158 B)

- 70 - Valutazione del Modello.mp4 (15.73 MiB)

- 71 - Metriche Mean Squared Error.mp4 (16.15 MiB)

- 71 - Notebook del laboratorio.txt (158 B)

- 72 - Metriche Root Mean Squared Error e Mean Absolute Error.mp4 (21.57 MiB)

- 72 - Notebook del laboratorio.txt (158 B)

- 73 - Metriche R2 - Coefficiente di Determinazione.mp4 (22.66 MiB)

- 73 - Notebook del laboratorio.txt (158 B)

- 74 - Eseguire Predizioni con il Modello.mp4 (109.23 MiB)

- 74 - Notebook del laboratorio.txt (158 B)

-

14 - Machine Learning Supervisionato - Classificazione

- 75 - Notebook del laboratorio.txt (158 B)

- 75 - Procuriamoci il Dataset di Tumori al Seno.mp4 (25.38 MiB)

- 76 - Creiamo il DataFrame.mp4 (47.62 MiB)

- 76 - Notebook del laboratorio.txt (158 B)

- 77 - Notebook del laboratorio.txt (158 B)

- 77 - Vettorizzazione delle Features.mp4 (49.36 MiB)

- 78 - Applichiamo la Standardizzazione.mp4 (52.12 MiB)

- 78 - Notebook del laboratorio.txt (137 B)

- 79 - Codifichiamo il Target.mp4 (48.43 MiB)

- 79 - Notebook del laboratorio.txt (137 B)

- 80 - Creare un Modello di Regressione Logistica.mp4 (12.61 MiB)

- 80 - Notebook del laboratorio.txt (137 B)

- 81 - Metriche L'Accuracy.mp4 (16.03 MiB)

- 81 - Notebook del laboratorio.txt (158 B)

- 82 - Metriche Precision e Recall.mp4 (29.44 MiB)

- 82 - Notebook del laboratorio.txt (158 B)

- 83 - Notebook del laboratorio.txt (158 B)

- 83 - Testiamo il modello sulle nuove Agobiopsie.mp4 (77.61 MiB)

-

15 - (Laboratorio) Sentiment Analysis sulle Recensioni di Yelp

- 84 - Introduzione alla Sentiment Analysis.mp4 (101.96 MiB)

- 85 - Notebook del laboratorio.txt (99 B)

- 85 - Procuriamoci il Dataset.mp4 (41.66 MiB)

- 86 - Creiamo il DataFrame.mp4 (109.48 MiB)

- 86 - Notebook del laboratorio.txt (99 B)

- 87 - Notebook del laboratorio.txt (99 B)

- 87 - Rimuoviamo la Punteggiatura.mp4 (50.34 MiB)

- 88 - Eseguiamo la Tokenizzazione.mp4 (43.69 MiB)

- 88 - Notebook del laboratorio.txt (99 B)

- 89 - Notebook del laboratorio.txt (99 B)

- 89 - Rimuoviamo le Stop Words.mp4 (40.25 MiB)

- 90 - Creiamo un modello Bag of Words.mp4 (155.51 MiB)

- 90 - Notebook del laboratorio.txt (99 B)

- 91 - Codifichiamo il Target.mp4 (64.29 MiB)

- 91 - Notebook del laboratorio.txt (99 B)

- 92 - Il Problema dell'Overfitting.mp4 (36.73 MiB)

- 92 - Notebook del laboratorio.txt (99 B)

- 93 - Applichiamo la Regolarizzazione.mp4 (25.64 MiB)

- 93 - Notebook del laboratorio.txt (99 B)

- 94 - Il Problema delle Classi Sbilanciate.mp4 (27.97 MiB)

- 94 - Notebook del laboratorio.txt (99 B)

- 95 - Bilanciamo il DataFrame e Creiamo il Modello.mp4 (75.93 MiB)

- 95 - Notebook del laboratorio.txt (99 B)

- 96 - Carichiamo il Dataset su un Bucket S3.mp4 (61 MiB)

- 96 - File JSON di Configurazione.txt (86 B)

- 97 - Creiamo il Cluster con EMR.mp4 (120.92 MiB)

- 98 - File JSON con il Zeppelin Note da Importare.txt (107 B)

- 98 - Il Modello TF IDF.mp4 (76.34 MiB)

- 99 - Cerchiamo delle Recensioni su TripAdvisor.mp4 (170.98 MiB)

- 100 - Preprocessiamo le nuove Recensioni.mp4 (54.18 MiB)

- 101 - Testiamo il modello sulle nuove Recensioni.mp4 (36.53 MiB)

-

16 - Spark Streaming

- 102 - Introduzione a Spark Streaming e al DStream.mp4 (31.9 MiB)

- 103 - Esempio di Echo Streaming.mp4 (55.94 MiB)

- 103 - Notebook del laboratorio.txt (93 B)

- 104 - Notebook del laboratorio.txt (93 B)

- 104 - Processare il DStream.mp4 (30.07 MiB)

- 105 - Esempio di Monitor di Keywords.mp4 (56.27 MiB)

- 105 - Notebook del laboratorio.txt (93 B)

- 106 - Creare uno Stato per il DStream.mp4 (131.73 MiB)

- 106 - Notebook del laboratorio.txt (93 B)

- 107 - Notebook del laboratorio.txt (93 B)

- 107 - Salvare il DStream in una Tabella SQL Temporanea.mp4 (56.35 MiB)

-

17 - (Laboratorio) Analisi in Tempo Reale dei Tweets pubblicati su Twitter

- 108 - Leggi qui prima di iniziare.html (1.5 KiB)

- 109 - Creiamo un Account Sviluppatore su Twitter.mp4 (72.53 MiB)

- 110 - Creiamo la nostra Twitter App.mp4 (33.53 MiB)

- 111 - Creiamo lo Stream dei Tweets.mp4 (86.01 MiB)

- 111 - Script del laboratorio.txt (88 B)

- 112 - Creiamo una Data Source Custom con un Socket.mp4 (76.85 MiB)

- 112 - Script del laboratorio.txt (88 B)

- 113 - Eseguiamo lo Stream dei Tweets con Spark.mp4 (30.36 MiB)

- 113 - Notebook del laboratorio.txt (95 B)

- 114 - Estraiamo gli Hashtags dai Tweets.mp4 (29.19 MiB)

- 114 - Notebook del laboratorio.txt (95 B)

- 115 - Creiamo un DataFrame con gli Hashtags più popolari.mp4 (153.04 MiB)

- 115 - Notebook del laboratorio.txt (95 B)

- 116 - Notebook del laboratorio.txt (95 B)

- 116 - Salviamo i Tweets in una Tabella SQL Temporanea.mp4 (97.65 MiB)

- 117 - Mostriamo gli Hashtags in un Grafico Dinamico.mp4 (103.23 MiB)

- 117 - Notebook del laboratorio.txt (95 B)

- 118 - (Bonus) Mostriamo gli Hashtags in un Grafico Dinamico.mp4 (81.42 MiB)

- 118 - Notebook del laboratorio.txt (95 B)

-

18 - Conclusione

- 119 - Scegli il tuo percorso.html (1.28 KiB)

- 120 - Non sai (ancora) programmare Parti da qui.html (3.15 KiB)

- 121 - Eseguire codice Python.mp4 (135.86 MiB)

- 122 - Input e output.mp4 (24.13 MiB)

- 123 - Variabili e tipi di dati.mp4 (23.11 MiB)

-

19 - Prerequisiti Programmazione con Python

- 124 - Gestire le eccezioni.mp4 (46.49 MiB)

- 125 - Formattazione.mp4 (45.01 MiB)

- 126 - Liste e tuple.mp4 (87.91 MiB)

- 127 - Set e frozenset.mp4 (70.15 MiB)

- 128 - I dizionari.mp4 (18.05 MiB)

- 129 - Il ciclo for.mp4 (85.46 MiB)

- 130 - Ciclo while ed espressioni booleane.mp4 (23.62 MiB)

- 131 - Istruzioni condizionali e operatori logici.mp4 (27.69 MiB)

- 132 - Le funzioni.mp4 (29.99 MiB)

- 133 - Classi e basi di programmazione ad oggetti.mp4 (56.04 MiB)

- 134 - pip e il Python Package Index.mp4 (15.89 MiB)

-

20 - Approfondimento Guida a Jupyter Notebook

- 135 - I comandi di base.mp4 (13.97 MiB)

- 136 - Formattare il testo con Markdown.mp4 (30.74 MiB)

- 137 - Inserire file multimediali.mp4 (35.45 MiB)

- 138 - Scrivere formule scientifiche con LaTeX.mp4 (33.56 MiB)

- 139 - Eseguire codice Python.mp4 (37.8 MiB)

- 140 - Utilizzare comandi di sistema.mp4 (9.55 MiB)

-

21 - Video Bonus

- 141 - Il Modello Bag of Words.mp4 (23.18 MiB)

- 142 - Il Modello TF IDF.mp4 (38.92 MiB)

- Read Me.txt (90 B)

-

Trackers

- udp://tracker.torrent.eu.org:451/announce

- udp://p4p.arenabg.com:1337/announce

- udp://explodie.org:6969/announce

- udp://tracker.opentrackr.org:1337/announce

- udp://tracker.coppersurfer.tk:6969/announce

- udp://tracker.pirateparty.gr:6969/announce

- udp://tracker.leechers-paradise.org:6969/announce

- udp://tracker.openbittorrent.com:6969/announce

- udp://opentracker.i2p.rocks:6969/announce

- udp://exodus.desync.com:6969/announce

- udp://ipv4.tracker.harry.lu:80/announce

- udp://open.stealth.si:80/announce

- udp://9.rarbg.me:2860

- udp://9.rarbg.to:2840

Commenti

Non ci sono commenti.

Accedi o iscriviti a ilCorSaRoNeRo per commentare questo torrent.